Просмотр видеороликов с новостями, жуткими трюками, котиками и миллионами вирусных лайфхаков стал неотъемлемой частью нашей жизни. На ролики в сети приходится более 80% трафика, и они давно стали предпочтительнее других типов контента. Но недавний "еврейский" скандал в соцсетях (ответ еврейских звезд Голливуда на футболку со свастикой от Канье Уэста) вызвал вопрос: как же отделить созданную ИИ подделку от подлинника? Тот же вопрос задают пользователи соцсетей, когда обнаруживают в пропаганде ХАМАСа "страдающих палестинцев" с 6 пальцами.

Ожидается, что внедрение генеративного ИИ еще больше увеличит просмотры созданных им роликов. Согласно данным исследовательской компании Grand View Research, в 2023 году рынок роликов от ИИ оценивался в 555 млн долларов, а за пять лет его объем увеличится почти в 4 раза - до 1,96 млрд долларов.

►Проблема дипфейка

Взрывной скачок популярности обнажил проблему роликов, сочетающих в себе ИИ и создающих сенсации. Фейковые ролики стали самой заметной проблемой технологии генеративного ИИ.

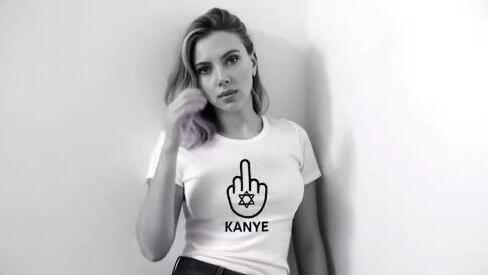

Поначалу некоторые из этих роликов были всего лишь пародиями, которые никто не воспринимал всерьез. Но на смену картинкам с надписями быстро пришли более вредоносные кадры. Самый свежий случай - ролик с отзывами на антисемитские высказывания Канье Уэста. В видео фигурируют созданные ИИ двойники голливудских знаменитостей еврейского происхождения. Ролик даже вызвал гневное возмущение у актрисы Скарлетт Йоханссон, которая тоже в него попала.

Но это проблема не только знаменитостей. Власти установили, что некоторые созданные ИИ ролики нарушают законы о неприкосновенности частной жизни и сексуальном насилии, причиняют вред детям и даже создают угрозы национальной безопасности, способствуя фальсификации выборов.

Понимая важность этой проблемы, Калифорния приняла недавно первый в штате закон о борьбе с дипфейками. Поясним, что слово дипфейк образовано от англ. deep fake (deep learning - "глубинное обучение" и fake - "подделка") и означает реалистичную подмену фото-, аудио- и видеоконтента, созданную с помощью ИИ.

Правила блокировки роликов от ИИ кажутся в лучшем случае расплывчатыми, и придется самим искать и определять, что реально, а что нет. На днях в журнале Forbes было опубликовано руководство из 5 способов, которые научат вас распознавать дипфейки.

Как распознать фейковый ролик: 5 способов

1. Синхронизация лица и губ

В роликах от ИИ, особенно в дипфейках, движения губ не соответствуют произнесенным словам. Это напоминает просмотр зарубежных фильмов с дублированным саундтреком. Это несоответствие указывает: ролик создан ИИ.

Кроме того, в этих роликах говорящие люди практически не моргают или моргают неестественно. Естественное моргание происходит у человека через нерегулярные промежутки времени и связано с разными моментами речи.

Кроме того, на фейк указывают слишком плавные или ограниченные мимические движения, что особенно заметно при внимательном просмотре. ИИ до сих пор не умеет контролировать эти нюансы, но можно не сомневаться, что этот недостаток будет вскоре устранен. Поэтому необходимы инструменты для распознавания роликов, созданных с помощью ИИ.

Дипфейк с Борисом Джонсоном от Canny AI

2. Инструменты для распознавания фейковых роликов

Первый из них - это Deepware, простой в использовании детектор ИИ. Он специализируется на дипфейках, анализируя несоответствия, последовательность кадров и искажения в выражениях лица.

Еще один полезный детектор - это WeVerify в расширении InVid Chrome для соответствующего браузера, который можно добавить как в Chrome, так и в другие браузеры Chromium - Microsoft Edge или Brave.

Плагин WeVerify даже занял первое место в конкурсе American Technology Challenge Paris 2021 и рекомендован некоммерческим Институтом журналистской этики Pointer. В любом случае, всегда полезно использовать несколько инструментов распознавания фейков для проверки результатов работы этого плагина.

3. Фоновые шумы и искажения

Генеративные платформы ИИ испытывает некоторые трудности с точной обработкой деталей фона и глубины резкости в видео.

Ролики, созданные ИИ, часто имеют небольшие искажения, проявляющиеся в виде шума, мерцания или необычных изменений фона. Эти искажения обычно связаны с ограничениями в процессах обработки данных ИИ. Однако можно не сомневаться, что со временем способности ИИ к обработке данных улучшатся.

4. Эмоциональная несовместимость

ИИ обладает странной способностью внедрять в свои видео натянутые диалоги, неловкие выражения лиц и неестественные микрожесты. Эти небольшие огрехи в совокупности создают несоответствие между эмоциональным тоном произнесенных слов и реакциями на сказанное. Опять же, разрыв незначителен, но он часто дает понять, что что-то в ролике не соответствует действительности.

5. Ролики воздействуют на человека сильнее, чем письменные послания

Мозг обрабатывает видео в 60.000 раз быстрее, чем текст. В результате после просмотра видео мы запоминаем 95% контента, а при чтении - всего 10%. Поэтому старайтесь проверять источники просмотренного ролика и его соответствие фактам, а также сопоставлять контент видео с другими источниками.

Всегда обращайте внимание на искажения, например, на исторические или фактические неточности. В сети можно встретить ролики, на которых якобы показан Иерусалим времен Ирода, хотя на заднем плане отчетливо видны мечети Храмовой горы, чего никак не могло быть.

Попадаются и ролики с шестипалыми палестинцами, изображающими жертв войны в Газе. Старайтесь обращать внимание на самые мелкие детали - и они помогут вам заподозрить, что вы смотрите дипфейк, порой с проблемным посланием.

Подробности на иврите читайте здесь

Перевод: Даниэль Штайсслингер